ChatGPT的那些事 -1- 背景资料

多处搬运,学无止境

目 录

1 关键词 1

1.1. AIGC(百度百科) 1

1.2. AlphaGo(百度百科) 1

1.3. ChatGPT(百度百科)

1.4.DALL-E / DALL-E 2

1.5 DeepMind 2(百度百科)

1.6. FAIR 3

1.7. NLP(自然语言处理)技术 (百度百科) 3

1.8. OpenAI (百度百科) 4

2. 背景介绍 4

2.1. ChatGPT的前世今生 5

3. 商业模式的通路与障碍 7

3.1. 商业模式的通路 *1 7

3.2. GPT应用的障碍 *1 8

4. GPT之技术演进时间线*3 9

5. Chat GPT主要特点*4 10

6. 参考资料 11

1关键词

1.1.AIGC(百度百科)

人工智能创作内容的生产方式。AIGC即AI Generated Content,是指利用人工智能技术来生成内容,AIGC也被认为是继UGC、PGC之后的新型内容生产方式,AI绘画、AI写作等都属于AIGC的分支。对AIGC来说,2022年被认为是其发展速度惊人的一年。

1.2.AlphaGo(百度百科)

阿尔法围棋(AlphaGo)是第一个击败人类职业围棋选手、第一个战胜围棋世界冠军的人工智能机器人,由谷歌(Google)旗下DeepMind公司戴密斯·哈萨比斯领衔的团队开发。其主要工作原理是“深度学习”。

2016年3月,阿尔法围棋与围棋世界冠军、职业九段棋手李世石进行围棋人机大战,以4比1的总比分获胜;2016年末2017年初,该程序在中国棋类网站上以“大师”(Master)为注册账号与中日韩数十位围棋高手进行快棋对决,连续60局无一败绩;2017年5月,在中国乌镇围棋峰会上,它与排名世界第一的世界围棋冠军柯洁对战,以3比0的总比分获胜。围棋界公认阿尔法围棋的棋力已经超过人类职业围棋顶尖水平。

2017年5月27日,在柯洁与阿尔法围棋的人机大战之后,阿尔法围棋团队宣布阿尔法围棋将不再参加围棋比赛。2017年10月18日,DeepMind团队公布了最强版阿尔法围棋,代号AlphaGo Zero。

2017年7月18日,教育部、国家语委在北京发布《中国语言生活状况报告(2017)》,“阿尔法围棋”入选2016年度中国媒体十大新词。

1.3.ChatGPT(百度百科)

ChatGPT,美国“开放人工智能研究中心”(OpenAI)研发的聊天机器人程序,于2022年11月30日发布。

ChatGPT?里面有两个词,一个是Chat?,指的是可以对话聊天。另外一个词,就是GPT。GPT?的全称,是Generative Pre-Trained Transformer(生成式预训练Transfomer模型)。ChatGPT?,词中共3个单词,Generative?生成式、Pre-Trained?预训练、和Transformer。

ChatGPT是人工智能技术驱动的自然语言处理工具,它能够通过学习和理解人类的语言来进行对话,还能根据聊天的上下文进行互动,真正像人类一样来聊天交流,甚至能完成撰写邮件、视频脚本、文案、翻译、代码等任务。

1.4.DALL-E / DALL-E 2

Dall-E,美国图像生成系统。

美国人工智能非营利组织OpenAI于2021年1月份推出Dall-E,这是一个可以根据书面文字生成图像的人工智能系统,该名称来源于著名画家达利(Dalí)和机器人总动员(Wall-E)。

该系统可以根据简单的描述创建极其逼真和清晰的图像,精通各种艺术风格,包括插画和风景等。它还可以生成文字来制作建筑物上的标志,并分别制作同一场景的草图和全彩图像。

DALL-E 2,是一种新的 AI 系统,可以从自然语言的描述中创建逼真的图像和艺术。

1.5.DeepMind(百度百科)

DeepMind,位于英国伦敦,是由人工智能程序师兼神经科学家戴密斯·哈萨比斯(Demis Hassabis)等人联合创立的Google旗下前沿人工智能企业。其将机器学习和系统神经科学的最先进技术结合起来,建立强大的通用学习算法。最初成果主要应用于模拟、电子商务、游戏开发等商业领域。

2017年10月18日,DeepMind团队公布了最强版阿尔法围棋,代号AlphaGo Zero。

1.6.Meta Reality Labs | FAIR(官网)

FAIR,全称 Facebook AI Research,即Facebook公司的AI研究中心。很多人并不是很了解Facebook这家公司,仅仅把 Facebook 当做一个社交媒体公司。实际上Facebook 是全球最先进的人工智能技术研究中心之一。

Facebook公司在2016年发布公司10年战略中,提出以AI为核心的三大战略:人工智能、AR/VR、连接。为了加快AI在商业领域的落地,2018年邀请前IBM 公司的Jerome Pesenti加盟,Pesenti曾作为CTO领导过IBM人工智能平台Watson的项目。

FAIR目前在加州的Menlo Park,纽约曼哈顿和法国巴黎有三个分部。研究方向相对自由宽松,研究所需的计算资源(如GPU)相对丰富,同时在2018年之前没有短期的产品压力,可以着眼长远做困难和本质的研究问题。这样的学术氛围除了MSR之外,在各大公司是极其少见的。

1.7.NLP(自然语言处理)技术(百度百科)

自然语言处理( Natural Language Processing, NLP),是计算机科学领域与人工智能领域中的一个重要方向。它研究能实现人与计算机之间用自然语言进行有效通信的各种理论和方法。自然语言处理是一门融语言学、计算机科学、数学于一体的科学。因此,这一领域的研究将涉及自然语言,即人们日常使用的语言,所以它与语言学的研究有着密切的联系,但又有重要的区别。自然语言处理并不是一般地研究自然语言,而在于研制能有效地实现自然语言通信的计算机系统,特别是其中的软件系统。因而它是计算机科学的一部分。

自然语言处理主要应用于机器翻译、舆情监测、自动摘要、观点提取、文本分类、问题回答、文本语义对比、语音识别、中文OCR等方面。

1.8.OpenAI(百度百科)

OpenAI,在美国成立的人工智能研究公司(https://openai.com/)。公司核心宗旨在于“实现安全的通用人工智能(AGI)”,使其有益于人类。

2015年,OpenAI由马斯克、美国创业孵化器Y Combinator总裁阿尔特曼、全球在线支付平台PayPal联合创始人彼得·蒂尔等硅谷科技大亨创立。

2016年6月21日,OpenAI宣布了其主要目标,包括制造“通用”机器人和使用自然语言的聊天机器人。OpenAI研发主管伊利娅·苏特斯科娃(Ilya Sutskever)、OpenAI CTO格雷格·布劳克曼(Greg Brockman)硅谷知名创业加速器Y Combinator总裁萨姆·阿尔特曼(Sam Altman)以及连续创业家埃隆·马斯克(Elon Musk)等人联合发表博文称:“我们正致力于利用物理机器人(现有而非OpenAI开发)完成基本家务。”

2019年7月22日,微软投资OpenAI 10亿美元,双方将携手合作替Azure云端平台服务开发人工智能技术。

2020年6月11日,OpenAI宣布了GPT-3语言模型,微软于2020年9月22日取得独家授权。

2022年6月,量子计算专家、ACM计算奖得主Scott Aaronson宣布,将加盟公司。

2023年2月2日,OpenAI宣布推出ChatGPT Plus订阅服务,可以让用户在高峰期优先使用人工智能聊天机器人 ChatGPT。

2.背景介绍*1

在过去十年间,谷歌、 Facebook、亚马逊、苹果和微软等硅谷科技巨头纷纷开启AI军备竞赛,先后成立专门的AI实验室,而最终业界公认的做纯AI研究的顶级实验室只有三家:背靠谷歌的DeepMind、背靠微软的OpenAI和背靠Facebook的FAIR。其中,被谷歌收购的DeepMind因拥有AlphaGo最为家喻户晓。

OpenAI在2015年底创立于旧金山,其联合创始人是马斯克以及硅谷知名孵化器Y Combinator的前掌门人奥特曼。不过,近年马斯克多以OpenAI的出资人角色出现,奥特曼才是这家公司的主导者和现任CEO。不到五年时间,OpenAI就依靠GPT-3跃升为全球AI领域顶级公司,与DeepMind并称AI圈的“双子星”。

事实上,Meta的Fair实验室也一直在自然语言处理(NLP)和对话型AI领域深耕,但其成果以发表论文为主,显得较为低调。今年6月,大举向元宇宙转型的Meta决定AI部门不再“集中化研究”,而是分布式下放,以便与实际业务结合,导致Fair的前途并不明朗。

OpenAI足以与AlphaGo一战的“武器”正是GPT-3,这个2020年推出的巨型语言处理模型怪兽,可以完成诸如答题、写论文、文本摘要、语言翻译和生成代码等壮举,其诞生被视作人工智能竞赛的里程碑事件。

2.1.ChatGPT的前世今生

如果梳理OpenAI的GPT(Generative Pre-trained Transformer)系列技术路线,可以探寻出OpenAI的布局思路。

OpenAI最初提出的GPT1,采取的是生成式预训练Transform模型(一种采用自注意力机制的深度学习模型),此后整个GPT系列都贯彻了这一谷歌2017年提出,经由OpenAI改造的伟大创新范式。

简要来说,GPT1的方法包含预训练和微调两个阶段,预训练遵循的是语言模型的目标,微调过程遵循的是文本生成任务的目的。

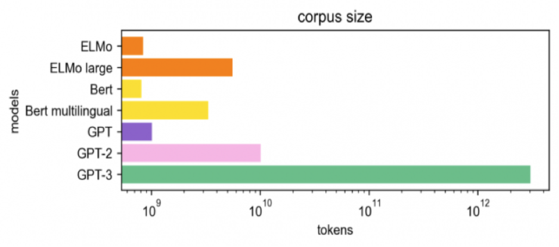

2019年,OpenAI继续提出GPT-2,所适用的任务开始锁定在语言模型。GPT2拥有和GPT1一样的模型结构,但得益于更高的数据质量和更大的数据规模,GPT-2有了惊人的生成能力。不过,其在接受音乐和讲故事等专业领域任务时表现很不好。

2020年的GPT3将GPT模型提升到全新的高度,其训练参数是GPT-2的10倍以上,技术路线上则去掉了初代GPT的微调步骤,直接输入自然语言当作指示,给GPT训练读过文字和句子后可接续问题的能力,同时包含了更为广泛的主题。

图源:Medium GPT系列模型的数据集训练规模

现在的ChatGPT则是由效果比GPT3更强大的GPT-3.5系列模型提供支持,这些模型使用微软Azure AI超级计算基础设施上的文本和代码数据进行训练。

具体来说,ChatGPT在一个开源数据集上进行训练,训练参数也是前代GPT-3的10倍以上,还多引入了两项功能:人工标注数据和强化学习,相当于拿回了被GPT-3去掉的微调步骤,实现了在与人类互动时从反馈中强化学习。

也因此,我们得以看到一个强大的ChatGPT,能理解人类不同指令的含义,会甄别高水准答案,能处理多元化的主题任务,既可以回答用户后续问题,也可以质疑错误问题和拒绝不适当的请求。

当初,GPT-3只能预测给定单词串后面的文字,而ChatGPT可以用更接近人类的思考方式参与用户的查询过程,可以根据上下文和语境,提供恰当的回答,并模拟多种人类情绪和语气,还改掉了GPT-3的回答中看似通顺,但脱离实际的毛病。

不仅如此,ChatGPT能参与到更海量的话题中来,更好的进行连续对话,有上佳的模仿能力,具备一定程度的逻辑和常识,在学术圈和科技圈人士看来时常显得博学而专业,而这些都是GPT-3所无法达到的。

3.商业模式的通路与障碍

3.1.商业模式的通路 *2

除了GPT系列之外,Open AI其实另有一条多模态领域研究支线闻名于世,即今年发布的明星产品——人工智能图像生成器DALL-E2。以DaLL E2为代表的Diffusion Model(扩散模型)几乎完成了此前爆火的AIGC(人工智能生成内容)领域的“大一统”,为AI绘画树立了全新标杆。

顶级技术能力之外,OpenAI能抢在谷歌和Meta之前重新书写AIGC版图,与其精细化的布局相关。

OpenAI月内的两笔收购都切中AIGC的增长点交叉地带,一桩投给了音频转录编辑器Descript ,一桩落子在AI笔记应用Mem。前者的处理场景刚好是文本、图片、音频以及视频,后者的技术底座是Transfomer模型,与ChatGPT同源。也就是说,OpenAI在打造自身处理下游任务的能力的同时,也在寻觅能承载下游任务的容器。

OpenAI的研究领域包括机器学习、自然语言处理和强化学习,其能在短短几年间迅速崛起,与创始人奥特曼对AI的创意性理解力密切相关:“十年前的传统观点认为,人工智能首先会影响体力劳动,然后是认知劳动,再然后,也许有一天可以做创造性的工作。现在看起来,它会以相反的顺序进行。”

在YC,奥特曼以激进大胆的投资风格著称,因其秉承直击腹地的简洁思维,备受创业者青睐。YC曾有创始人称奥特曼为“创业公司的尤达大师”(《星球大战》中的绝地武士导师)。

这位CEO还有着实事求是的性情,当外界对GPT-3的能力发出铺天盖地的赞美时,他反而说“GPT-3被吹捧得太过了”。此后GPT-3在一系列问答中闹出笑话、表现不佳,也印证了他的说法。

但奥特曼的冷静挡不住幕后金主马斯克对ChatGPT抱持的极大热情,他十分关注ChatGPT的商业化前景,并在推特上向奥特曼提问,“ChatGPT每回答一个问题的成本是多少?”奥特曼则如实地答道:“每次对话的平均费用可能只有几美分,我们正试图找出更精确的测量方法并压缩费用。”

实际上,谷歌和Meta等巨头目前都尚未将生成式AI领域的研究能力转化为商业化部署,作为创业公司的OpenAI却做了不少尝试。

这家公司曾希望通过API(应用编程接口)方式来推动GPT-3的技术商业化,在2020年6月就开放了GPT-3的API接口,并曾与十余家公司展开过初步的商用测试,但由于GPT-3的功能并不完善未见成效。曾有传言称OpenAI为GPT3投入了至少1000万美元,为了摆脱入不敷出的窘境,才将GPT3作为一项付费服务来推广。

Facebook改名为Meta之后,Meta AI实验室在5月宣布开放自己的语言大模型OPT(预训练变换模型),而OPT一直对标OpenAI的GPT3。与之类似,硅谷大厂内部都有对标GPT3的产品,只是因为大厂都是关起门来做私密研究,因而不为外界所知。

某种程度上,ChatGPT采取免费试用是OpenAI准备继续打磨这款产品的信号,用户给予的反馈会帮助该模型吸取足够的信息量,从而作出更恰当的反应。从GPT-3开始,ChatGPT及尚未出炉的GPT-4都面临训练成本过大的问题。有分析指出,是否收费是个两难决策:如果继续免费,OpenAI会无法承受,但收费又会极大减少用户基数。倘若训练成本能大幅下降,则两难自解。

此外,GPT-3历经两年商业化尝试,并未“如愿”取代记者编辑或码农的职业生涯,OpenAI也从中发现,将GPT系列作为辅助生产力工具对商业化更为合适。此前业内传言微软对这家公司的新一轮注资即将落地,届时其估值预计超过200亿美元,商业化也必将提上日程。到那时,OpenAI可以倚仗的大概率是ChatGPT,或者是通过了图灵测试的GPT4。

3.2.GPT应用的障碍 *2

一片叫好声中,也不乏有人泼来冷水——程序员首选问答社区Stack Overflow日前便宣布,禁止用户复制ChatGPT的答案来回答其它用户的问题,理由是ChatGPT的答案正确比率太低,日后待社区讨论后再作出解禁决定。

此举立刻引发了业界普遍关注,仿佛是对ChatGPT编程价值的彻底否定。与此同时,人工智能界的专家们也在激辩这些大型语言模型可能带来的负面效应,比如Meta的首席人工智能科学家Yann LeCun认为,虽然它们会有错误信息和不良输出,但并不会使文本的实际分享变得容易,而后者才是造成危害的真正原因。但也有人反驳称,这些语言系统的廉价文本生成能力,必然会增加其后被分享的风险。

3.3.Chat GPT技术 *3

ChatGPT 能够实现当前的交互,离不开 OpenAI 在 AI 预训练大模型领域的积累。OpenAI 是微软投资的 AI 实验室,也是全球 AI 领域最为领先的 AI 实验室之一,一直因为技术层面的领先,被当作是 AI 领域的行业“灯塔”。

从 2018 年起,OpenAI 就开始发布生成式预训练语言模型 GPT(Generative Pre-trained Transformer),可用于生成文章、代码、机器翻译、问答等各类内容。在当时,参数量只有 1.17 亿。

接下来,OpenAI 每一代 GPT 模型的参数量都爆炸式增长,2019 年 2 月发布的 GPT-2 参数量为 15 亿,而 2020 年 5 月的 GPT-3,参数量达到了 1750 亿,直接带动了预训练大模型成为 AI 领域近两年的发展趋势,掀起一场拼参数、拼算力的军备竞赛。

GPT-4 还未到来,这一次发布的 ChatGPT,被视为是基于 GPT-3 的微调版本,即 GPT-3.5。

OpenAI 表示,ChatGPT 采用的模型使用了“利用人类反馈强化学习(RLHF)”的训练方式,包括了:人类提问机器答、机器提问人类回答,并且不断迭代,让模型逐渐有了对生成答案的评判能力。相比 GPT-3,ChatGPT 的主要提升点在于记忆能力,可实现连续对话,极大地提升了对话交互模式下的用户体验。

4.Chat GPT主要特点 *5

ChatGPT本质是一个对话模型,它可以回答日常问题、进行多轮闲聊,也可以承认错误回复、挑战不正确的问题,甚至会拒绝不适当的请求。在上周公布博文和试用接口后,ChatGPT很快以令人惊叹的对话能力“引爆”网络。

(1)ChatGPT的技术背景

ChatGPT目前未释出论文文献,仅释出了介绍博文和试用API。从博文中提供的技术点和示意图来看,它与今年初公布的InstructGPT 核心思想一致。其关键能力来自三个方面:强大的基座大模型能力(InstructGPT),高质量的真实数据(干净且丰富),强化学习(PPO算法)。以上ChatGPT成功的三个要素,具体将在文中第2部分详细展开。

(2)ChatGPT的主要特点

让用户印象最深刻的是它有强大的语言理解和生成系统。其对话能力、文本生成能力、对不同语言表述的理解均很出色。它以对话为载体,可以回答多种多样的日常问题,对于多轮对话历史的记忆能力和篇幅增强。其次,与GPT3等大模型相比,ChatGPT回答更全面,可以多角度全方位进行回答和阐述,相较以往的大模型,知识被“挖掘”得更充分。它能降低了人类学习成本和节省时间成本,可以满足人类大部分日常需求,比如快速为人类改写确定目标的文字、大篇幅续写和生成小说、快速定位代码的bug等。

值得一提的事,它具有安全机制和去除偏见能力。下图这类问题在以前的大模型中时常出现,然而ChatGPT在这两点上增加了过滤处理机制。针对不适当的提问和请求,它可以做出拒绝和“圆滑”的回复。

5.GPT之技术演进时间线 *4

GPT从开始至今,其发展历程如下:

(1)2017年6月,Google发布论文《Attention is all you need》?,首次提出Transformer模型,成为GPT发展的基础。 论文地址:https://arxiv.org/abs/1706.03762

(2)2018年6月,OpenAI 发布论文《Improving Language Understanding by Generative Pre-Training》(通过生成式预训练提升语言理解能力)?,首次提出GPT模型(Generative Pre-Training)。论文地址:https://paperswithcode.com/method/gpt。

(3)2019年2月,OpenAI 发布论文《Language Models are Unsupervised Multitask Learners》(语言模型应该是一个无监督多任务学习者),提出GPT-2模型。论文地址:https://paperswithcode.com/method/gpt-2

(4)2020年5月,OpenAI 发布论文《Language Models are Few-Shot Learners》(语言模型应该是一个少量样本(few-shot)学习者,提出GPT-3模型。论文地址:https://paperswithcode.com/method/gpt-3

(5)2022年2月底,OpenAI 发布论文《Training language models to follow instructions with human feedback》(使用人类反馈指令流来训练语言模型)?,公布Instruction GPT模型。论文地址:https://arxiv.org/abs/2203.02155

(6)2022年11月30日,OpenAI推出ChatGPT模型,并提供试用,全网火爆。详见:AI-001-火爆全网的聊天机器人ChatGPT能做什么

6.参考资料

*1.ChatGPT的前世今生:风靡全网的“最强AI”是如何做到这一切的?-36氪 (36kr.com)

*2.「深度」ChatGPT的前世今生:风靡全网的“最强AI”是如何做到这一切的? (baidu.com)

*3.别被火爆全网的 ChatGPT“骗了” - IT之家 (ithome.com)

*4.十分钟理解ChatGPT的技术逻辑及演进(前世、今生)-51CTO.COM

*5.算法工程师深度解构ChatGPT技术 - 腾讯云开发者社区-腾讯云 (tencent.com)